Spring Boot 实现策略模式的正确姿势!

一、背景介绍

一说起策略设计模式,相比大家都不陌生,在实际的业务开发中,合理的使用设计模式来编程,可以让代码阅读起来层次感更强,同时扩展性也会得到提升!

最近…

一文搞懂大模型RAG应用(附实践案例)

写在前面

大模型(Large Language Model,LLM)的浪潮已经席卷了几乎各行业,但当涉及到专业场景或行业细分领域时,通用大模型就会面临专业知识…

万字长文慎入!AI 智能体架构在推理、规划和工具调用方面的现状揭秘!

—— 爽姐

TOP 级信息安全公司 10年+ 高级研发

约 4 万人 AI 社区破局俱乐部初创合伙人

破局大航海 AI 编程教练

…

【由浅到深】从神经网络原理、Transformer模型演进、到代码工程实现

阿里妹导读

阅读这个文章可能的收获:理解AI、看懂模型和代码、能够自己搭建模型用于实际任务。

开场

大模型的文章太多了,良莠不齐,要么太专业,上来一堆概念,…

图解布隆过滤器和布谷鸟过滤器实现原理

布隆过滤器和布谷鸟过滤器是两种概率型数据结构,主要用于高效的检査一个元素是否属于一个集合,但是在实现实现、性能特性和使用场景上存在一定的差异,下面我们来聊聊这两…

什么是LoRA模型,如何使用和训练LoRA模型?你想要的都在这!

什么是LoRA模型

LoRA的全称是LoRA: Low-Rank Adaptation of Large Language Models,可以理解…

Moe已成为现阶段LLM的新标准——人工智能、AI

在当前快节奏的人工智能世界中,事物来来去去,一切变化都如此之快。

大模型一直在不断的更新,也一直在不断地改进,要找到大模型演进的方向,就要找那些无处不在的改变。…

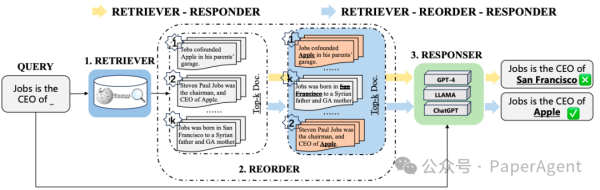

阿里RAG新框架R4:增强检索器-重排序-响应器,5个知识密集任务上都超过Self-RAG等!

大型语言模型(LLMs)在生成文本时可能会产生错误信息,即“幻觉”问题。尽管检索增强的LLMs通过检索外部数据来减少这种幻觉,但现有的方法通常不考虑检索文档与L…

必读:系统学习大模型必读的20篇论文

【引子】“脚踏实地,仰望星空”, 知其然还要知其所以然。读论文是一条重要的途径,这一篇文章https://magazine.sebastianraschka.c…

一文读懂「Lang Chain」langchain

一、什么是LangChain?

LangChain是一个强大的框架,旨在帮助开发人员使用语言模型构建端到端的应用程序。它提供了一套工具、组件和接口,可简化创建…

人工智能大语言模型微调技术:SFT 监督微调、LoRA 微调方法、P-tuning v2 微调方法、Freeze 监督微调方法

1.SFT 监督微调

1.1 SFT 监督微调基本概念

SFT(Supervised Fine-Tuning)监督微调是指在源数据集上预训练一个神经网络模型,即…

Hugging Face 超详细介绍和使用教程

文章目录

一、前言

二、可以获得什么?

三、入门实践

3.1 帮助文档

3.2 安装

3.3 模型的组成

3.4 BERT模型的使用

3.4.1 导入…