选微调、RAG还是微调+RAG?

一、RAG (Retrieval Augmented Generation)

RAG技术是一种结合了检索与生成的方法。它通常依赖于两个核心组件:一个大型语言模型(如GPT-3)和一个检索系统(如向量数据库)。RAG先使用检索系统从大量数据中检索出相关信息,然后将这些信息提供给语言模型,以便生成回答或文本。这样,RAG能够利用语言模型的强大生成能力以及检索系统提供的具体信息。

RAG这种方法将检索(或搜索)的能力集成到LLM中。它结合了一个检索系统和一个大模型,前者从大型语料库中获取相关文档片段,后者使用这些片段中的信息生成答案。本质上,RAG 帮助模型“查找”外部信息以改进其响应。

RAG特点

-

知识维度:RAG能够快速更新知识库,仅通过更新数据库来反映最新信息,无需重新训练模型。

-

效果维度:RAG在稳定性和可解释性方面表现较好,因为其生成的回答基于检索到的具体事实。

-

成本维度:在推理时,RAG需要额外的检索步骤,这可能增加实时性的成本。

RAG优势

-

更新知识快:只需更新数据库,无需重新训练模型。

-

稳定性较好:基于事实的检索结果可以提高回答的准确性。

-

可解释性:检索到的信息可以作为生成回答的依据。

RAG劣势

-

检索依赖:检索系统的质量直接影响最终效果。

-

增加实时性成本:检索过程需要额外的时间和计算资源。

二、微调(Fine-tuning)

微调是在预训练好的大型模型的基础上,使用特定领域的较小数据集来进一步训练模型的过程。通过这个过程,模型能够学习特定领域的知识,提高在特定任务上的表现。

微调采用预先训练的 LLM 并在较小的特定数据集上对其进行进一步训练的过程,以使其适应特定任务或提高其性能。通过微调,我们根据数据调整模型的权重,使其更适合我们应用程序的独特需求。

微调特点

-

知识维度:微调通过训练使模型获得新的领域知识,需要相对足量的领域数据。

-

效果维度:对于简单的任务,微调可能达到更高的效果上限,因为它可以针对性地调整模型参数。

-

成本维度:微调需要大量的计算资源(如GPU),且训练时间较长。

微调优势

-

领域适应性:能够学习特定领域的深入知识。

-

性能潜力:对于简单任务,可能达到比RAG更高的性能。

微调劣势

-

资源消耗大:需要大量的计算资源和时间进行训练。

-

知识遗忘:容易遗忘未在训练数据中出现的知识。

三、RAG和微调的适应场景

-

知识更新:RAG通过更新数据库来更新知识,微调则是通过重新训练来吸收新知识。

-

效果稳定性:RAG通常在生成回答时更稳定,而微调可能达到更高的性能上限。

-

资源消耗:微调在训练时消耗资源较多,RAG在推理时增加额外的检索成本。

RAG适用场景

-

知识需要快速更新的领域。

-

对实时性要求不是特别高的应用场景。

-

需要高度可解释性或准确性的场景。

微调适用场景

-

数据量较小但质量高的领域。

-

对模型效果有较高要求,且可以承担相应计算资源消耗的场景。

-

领域知识比较独特,需要模型深入学习的场景。

四、RAG+微调

RAG和微调各自有优势,在某些场景下结合使用可以发挥各自的长处,提高整体的效果和效率。以下是在哪些场景下需要结合使用RAG和微调的一些建议:

-

复杂且知识密集的任务:对于需要深入领域知识和广泛背景信息的问题,单独使用RAG可能无法覆盖所有细节,而微调可以帮助模型更好地理解这些细节。

-

数据更新频繁的场景:在数据经常变化的情况下,使用RAG可以快速更新知识库,而微调可以帮助模型适应新的数据分布。

-

对实时性要求高的场景:如果单独使用RAG,检索步骤可能会增加延迟。通过微调优化模型,可以减少对检索系统的依赖,提高响应速度。

-

资源受限的场景:在资源有限的情况下,可以先使用RAG来减少需要微调的数据量,然后对关键或难以检索的信息进行微调。

RAG和微调相有如下的集中结合方式:

-

分阶段训练:

-

初步使用RAG:首先使用RAG来处理任务,利用其检索能力快速获取相关信息。

-

识别不足:分析RAG在处理任务时的不足,识别模型难以处理或经常出错的情况。

-

针对性微调:对识别出的问题进行数据收集,然后使用这些数据对模型进行微调,以改进模型在这些特定情况下的表现。

- 联合训练:

-

同时训练检索和生成:在微调过程中,可以同时训练检索组件和语言模型,使得两者能够更好地协同工作。

-

使用伪标签:可以使用生成模型生成的伪标签来训练检索组件,反之亦然。

- 迭代优化:

-

循环迭代:先使用RAG生成回答,然后使用这些回答进行微调,接着用微调后的模型来优化检索组件,形成一个迭代优化的闭环。

- 领域适应:

-

先微调后RAG:对于领域适应性要求高的场景,可以先对模型进行微调以适应特定领域,然后使用RAG来补充微调未覆盖的知识。

通过这样的结合使用,可以充分利用RAG的快速知识检索能力和微调的深度知识学习能力,提升模型在复杂任务上的表现。同时,这种结合也可以帮助平衡实时性、准确性和资源消耗等多方面的需求。

五、基于微调+RAG的项目案例:特定主题的问答系统

以下是简化的项目案例,我们将结合使用RAG和微调来构建一个问答系统,该系统旨在回答有关特定主题的问题。这个案例将展示如何利用RAG来快速获取信息,并使用微调来提高回答的准确性和适应性。

假设我们有一个大型语言模型(如GPT-2)和一个向量数据库,我们希望创建一个能够回答有关“太空探索”主题的问题的系统。主要实现步骤包括:

- 准备数据集

-

收集一个包含关于“太空探索”主题的问题和答案的数据集。

-

将数据集分为训练集和验证集。

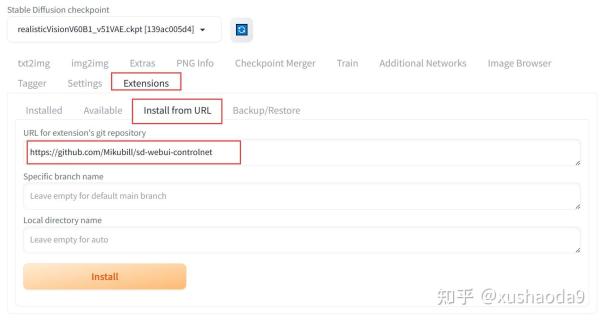

- RAG检索组件配置

-

使用向量数据库来存储与“太空探索”主题相关的文档。

-

配置检索系统,使其能够从数据库中检索与输入问题相关的文档。

- 初步微调

-

使用训练集对大型语言模型进行初步微调,以使其适应“太空探索”主题。

- RAG与微调结合

-

结合使用RAG和微调来构建问答系统。

# 导入必要的库

from transformers import GPT2LMHeadModel, GPT2Tokenizer

from retriever import VectorDBRetriever # 假设的检索器库

import torch

# 初始化模型和分词器

model = GPT2LMHeadModel.from_pretrained('gpt2')

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

# 初始化向量数据库检索器

retriever = VectorDBRetriever('space_exploration') # 假设的数据库

# 微调模型

def fine_tune(model, tokenizer, train_dataset):

# 微调代码省略,通常包括数据加载、模型训练等步骤

# RAG流程

def rag_process(question):

# 检索相关信息

relevant_docs = retriever.retrieve(question)

# 使用检索到的文档生成回答

context = ' '.join(relevant_docs)

input_ids = tokenizer.encode(f'{question}{context}', return_tensors='pt')

output = model.generate(input_ids, max_length=100, num_return_sequences=1)

answer = tokenizer.decode(output[0], skip_special_tokens=True)

return answer

# 微调后的RAG流程

def fine_tuned_rag_process(question):

# 微调模型

fine_tune(model, tokenizer, train_dataset)

# 使用微调后的模型进行RAG流程

return rag_process(question)

# 示例问题

question = "What is the Hubble Space Telescope?"

answer = fine_tuned_rag_process(question)

print(answer)请注意,以上代码是伪代码,仅用于说明概念。实际的实现会涉及到详细的模型微调流程、数据预处理、向量数据库的集成等步骤。

- 数据准备:确保数据集的质量和覆盖面,这对微调的效果至关重要。

- 微调策略:选择合适的微调策略,如学习率、批次大小、训练轮数等。

- 检索组件:根据问题构建高效的检索系统,确保能够快速准确地检索到相关文档。

通过结合使用RAG和微调,我们可以构建一个既具有广泛知识背景,又能针对特定领域进行深度学习的问答系统。